구글이 인공지능(AI) 서비스의 환경영향을 측정하는 포괄적 방법론을 제시하고 실제 데이터를 최초로 공개했다. 구글 클라우드는 자사의 AI 모델 ‘제미나이’의 환경영향을 측정한 기술 논문인 ‘AI 추론의 환경영향 측정(Measuring the environmental impact of AI inference)’ 기술 논문을 현지시각 21일 발표했다. 해당 논문에는 제미나이의 추론 과정에서 발생하는 에너지의 소비량과 탄소 배출량, 물 사용량을 종합적으로 분석한 방법론에 대한 내용이 담겼다.

논문에 따르면 제미나이 앱에서 텍스트를 생성하는 프롬프트(질문) 하나당 0.24Wh(와트시)의 에너지를 소비하는 것으로 나타났다. 이는 TV를 9초간 시청할 때와 같은 수준이다. 탄소 배출량은 0.03g CO² 상당량, 물 소비량은 0.26㎖(약 5방울)로 측정됐다. 구글 클라우드는 “많은 공개 추정치보다 상당히 낮은 수준”이라고 설명했다.

앞서 업계에서는 데이터센터에서 활용하는 에너지의 수준은 구글 클라우드가 발표한 수준의 10배 수준으로 예측했다. 구글 크롬을 통한 일반 검색은 0.3Wh 수준인데 반해 오픈AI의 챗GPT에 프롬프트를 넣는 질의 1건당 예상 전력소모량은 2.9Wh 수준이었다. 미국 전력연구소(EPRI)의 분석에 따르면, AI 쿼리(개별적인 AI 모델의 데이터 요청 및 처리)는 일반 검색보다 10배 더 많은 전력을 소모하고, AI 데이터센터는 전통 데이터센터보다 랙당 5∼10배 높은 전력 밀도를 필요로 한다는 것이 업계의 분석이었다.

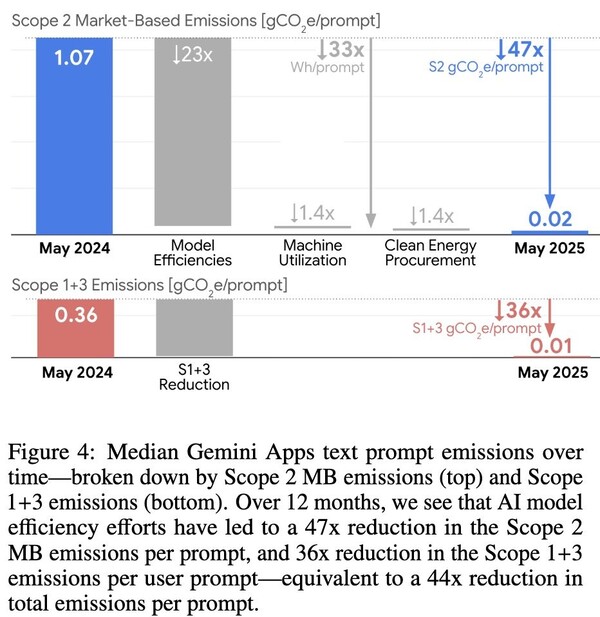

구글 클라우드의 논문을 통해 주목할 점은 효율성 개선 속도였다. 지난해 5월부터 지난 5월까지 12개월간 제미나이의 프롬프트당 에너지 사용량과 총 탄소 발자국은 각각 33분의 1, 44분의 1로 감소했다. 응답 품질은 오히려 향상된 것으로 평가했다.

구글이 이번에 제시한 측정 방법론의 핵심은 ‘포괄성’이다. 기존 AI 에너지 소비 계산은 주로 활성 상태의 TPU와 GPU만 고려했다. 하지만 실제 서비스 환경에서는 △높은 가용성과 신뢰성을 위한 대기 상태 장비 △CPU와 RAM 사용량 △데이터센터 냉각·전력분배 등 인프라 오버헤드 △물 소비량 등 여러 요소가 에너지를 소비한다.

구글의 분석에 따르면 활성 TPU와 GPU 소비량만 고려하는 기존 방식으로는 프롬프트당 에너지 사용량이 0.1Wh로 나타나지만, 모든 요소를 포함하면 0.24Wh로 증가한다. 구글은 "기존 계산법은 이론적 효율성을 나타낼 뿐 대규모 실제 운영 효율성을 크게 과소평가한다"고 지적했다.

제미나이의 극적인 효율성 향상은 구글의 ‘풀스택 접근법’ 덕분이다. 맞춤형 하드웨어부터 고효율 모델, 강력한 서빙 시스템까지 AI의 모든 계층에 효율성을 구축한 결과다.

먼저 모델 아키텍처 차원에서 구글 연구진이 개발한 트랜스포머 아키텍처를 기반으로 하는 제미나이는 기존 언어모델링 최신 기술 대비 10~100배 효율성 향상을 달성했다. 전문가 혼합(MoE) 구조를 통해 전체 대형 모델 중 쿼리 응답에 필요한 작은 부분만 활성화해 연산과 데이터 전송을 10~100분의 1로 줄일 수 있었다. 여기에 정확한 양자화 훈련(AQT) 등 효율적 알고리즘을 적용해 응답 품질 저하 없이 서빙 에너지 소비를 최소화했다.

추론 과정에서는 추측적 디코딩 기술을 활용해 작은 모델이 예측을 수행하고 큰 모델이 빠르게 검증하는 방식으로 더 적은 칩으로 더 많은 응답을 서빙할 수 있게 했다. 증류(distillation) 기법으로는 더 큰 모델을 교사로 활용해 더 작고 효율적인 모델들(제미나이 플래시, 플래시 라이트)도 개발했다.

하드웨어 측면에서 구글은 10년 넘게 와트당 성능을 최대화하도록 TPU를 설계해왔다. AI 모델과 TPU를 함께 설계해 소프트웨어가 하드웨어를 최대한 활용하도록 한 결과, 최신 TPU인 ‘아이언우드’는 구글 첫 번째 공개 TPU 대비 30배 높은 에너지 효율을 달성했고 추론용으로는 범용 CPU보다 훨씬 전력 효율적이다.

운영 차원에서는 서빙 스택이 수요에 따라 실시간으로 모델을 동적 이동시켜 CPU를 고효율로 사용하고 TPU 대기 시간을 최소화한다. 마지막으로 데이터센터 자체도 업계 최고 효율을 자랑하며, 전체 평균 전력사용효율(PUE)이 1.09에 달한다. 24/7 무탄소 에너지 목표 추진과 함께 오피스와 데이터센터에서 소비하는 담수의 120%를 평균적으로 보충하는 것도 목표로 하고 있다.

구글은 이번 방법론과 연구 결과 공개를 통해 AI의 자원 소비와 효율성 계산에서 업계 전반의 일관성을 높이겠다고 밝혔다.

구글은 “AI 수요가 증가하고 있는 만큼 프롬프트당 전력 공급 비용과 물 사용량을 줄이는 데 막대한 투자를 하고 있다”며 “연구 결과와 방법론을 공유해 더 효율적인 AI를 향한 업계 전반의 AI 효율 향상을 촉진하고자 한다”고 밝혔다. 이어 “이는 책임감 있는 AI 개발에 필수적”이라고 덧붙였다.

제프 딘(Jeff Dean) 구글 딥마인드 및 구글 리서치 수석 과학자는 “구글의 제미나이, 소프트웨어 및 하드웨어 인프라, 데이터센터 운영, 청정 에너지 조달 및 기타 여러 측면에서 일하는 수많은 사람들이 최고의 효율성으로 AI 모델을 제공하기 위한 이러한 지속적인 노력에 크게 기여하고 있다”고 강조했다.