인공지능(AI)의 눈 역할을 하는 ‘비전 AI’가 현실을 잘못 해석해 엉뚱한 판단을 내리는 ‘할루시네이션’ 현상을 해결할 수 있는 기술이 국내 연구진에 의해 개발됐다. 최진우 경희대 소프트웨어융합대학 컴퓨터공학과 교수팀과 LG AI연구원이 공동으로 진행한 이번 연구는 영상 속 동작과 장면을 혼동하는 비전 AI의 구조적 한계를 밝혀내고, 이를 효과적으로 줄일 수 있는 해법을 제시했다. 자율주행, 의료 진단, 보안 시스템 등 실사용 분야에서의 신뢰도를 크게 높일 수 있는 전환점으로 평가된다.

4일 최진우 교수는 부산 벡스코에서 열린 KCCV(Korean Conference on Computer Vision) 2025에서 비전 AI가 영상을 잘못 해석하는 ‘액션-장면 환각(Action-Scene Hallucination)’ 현상을 분석하고, 이 오류의 구조적 원인을 규명하는 동시에 이를 해결하는 새로운 모델 아키텍처를 발표했다.

연구팀은 GPT-4V 등 최신 비전 AI가 눈 덮인 주차장에서 쇼핑카트를 미는 영상을 “쇼핑몰에서 쇼핑 중”으로 판단하거나, 선수가 없는 아이스하키 링크를 “관중이 가득한 경기장”이라고 오인하는 등 환각 사례를 구체적으로 분석했다. 이러한 문제는 단순한 성능 지표로는 드러나지 않지만, 실제 적용 상황에서는 치명적 오류로 이어질 수 있어 해결이 시급한 과제로 지목돼 왔다.

이번 연구는 제1저자인 배경호 경희대 연구원을 비롯해 LG AI연구원의 김진형·이시행·이순영 연구원이 참여했다. 경희대 최진우 교수와 LG AI연구원의 이건희 연구원이 교신저자로 이름을 올렸다.

◇ 환각 오류의 정체… 행동과 장면 간 ‘뒤섞임’이 문제였다

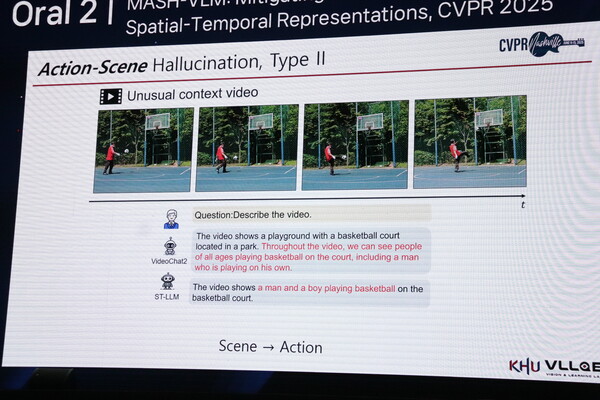

연구팀은 비전 AI 환각을 세 가지 유형으로 분류했다. 장면 정보만 보고 존재하지 않는 행동을 상상하는 경우, 배경에 이끌려 실제 동작을 잘못 해석하는 경우, 반대로 동작을 보고 장면을 오인하는 경우다.

예컨대 농구장에서 축구공을 차는 장면을 보고 “농구를 하고 있다”고 판단하거나, 도서관에서 벌어진 권투 장면을 “권투장”으로 인식하는 식이다.

최 교수는 “비전 AI가 높은 성능을 보이는 것처럼 보이지만, 장면과 행동 정보를 혼동하는 근본적인 문제가 있었다”며 “이 문제는 실제 환경에서 큰 위험 요소가 될 수 있다”고 지적했다. 연구팀은 이러한 환각이 모델 내부에서 공간 정보(spatial)와 시간 정보(temporal)가 서로 간섭하며 잘못된 상관관계를 학습하는 구조적 문제에서 비롯된다는 사실을 밝혀냈다. 특히 위치 정보를 부여하는 방식에서 토큰 유형 간 불균형이 존재해 특정 정보에 편향되는 현상이 문제로 확인됐다.

◇ ‘MASH’로 환각 줄이고 성능 유지… 산업 적용도 염두

해결책으로 제안된 ‘매쉬(MASH)’ 기법은 두 가지 핵심 아이디어로 구성된다. 공간 토큰과 시간 토큰의 직접적인 상호작용을 차단해 정보 간 간섭을 방지하는 ‘DST(Disentangled Spatial-Temporal) 어텐션’, 그리고 서로 다른 유형의 토큰들이 텍스트와 동등한 상대적 거리에서 처리되도록 위치 임베딩을 조정하는 ‘하모니 RoPE(Harmony Rotary Position Embedding)’ 방식이다. 이름 MASH는 다양한 정보를 ‘으깨서 섞는’ 방식의 개선 구조를 의미하며, 기존 아키텍처에 두 가지 아이디어만 추가한 경량 구조로 구현됐다.

연구팀은 자체 구축한 테스트 데이터셋인 ASVD(Action-Scene Video Dataset)를 통해 MASH 기법의 효과를 검증했다. 실험 결과, 기존 모델이 눈밭에서 골프를 치는 영상을 “스키를 타고 있다”고 오판한 데 비해, MASH 모델은 “골프를 하고 있다”고 정확하게 인식하는 등 환각 현상을 크게 줄이면서도 일반적인 비디오 이해 성능은 유지되거나 오히려 향상되는 성과를 보였다.

이번 연구는 경희대가 이론적 프레임워크를 설계하고 LG AI연구원이 대규모 실험과 구현을 담당하는 방식으로 이뤄진 산학협력의 성과다. 최 교수는 “이번 연구는 논문을 위한 모델 성능 경쟁이 아니라, 실제 산업 현장에서 적용 가능한 실용 기술을 만드는 데 초점을 맞췄다”며 “앞으로 장시간 영상 이해나 다양한 형태의 환각 문제로 연구를 확장해 나갈 계획”이라고 밝혔다.