메타가 14일(현지시각) 새로운 비전 파운데이션 모델 ‘다이노(DINO)v3’를 공개했다. 인간의 라벨링 작업 없이 17억 개의 이미지로 훈련된 모델이다. 다양한 시각 인식 태스크에서 기존의 전문화된 모델들을 뛰어넘는 성능을 보여준다.

◇ 라벨링의 한계 넘어선 자기지도 학습

다이노v3의 핵심은 자기지도 학습이다. 기존 모델들이 사람이 만든 설명이나 라벨에 의존했다면, 다이노v3는 이미지만 보고 스스로 학습한다. 규모도 크다. 70억 개의 매개변수로 구성됐고, 이전 버전보다 7배 큰 모델을 12배 많은 데이터로 훈련했다.

가장 주목할 점은 하나의 모델로 여러 일을 동시에 처리한다는 것이다. 객체 찾기, 영역 나누기, 동영상 추적 등을 별도 훈련 없이 바로 수행한다. 마치 만능 도구처럼 작동한다. 메타 연구진은 “라벨 없이 학습한 모델이 라벨을 사용한 기존 모델들보다 더 좋은 성능을 보였다”고 설명했다.

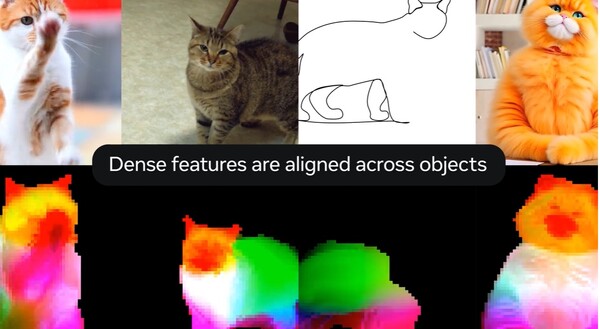

다이노v3의 강점은 이미지를 매우 세밀하게 분석한다는 점이다. 사진의 모든 부분을 꼼꼼히 살펴보고, 객체들을 정확히 구분해낸다. 다른 종류의 물체들도 잘 인식한다. 이런 특성 덕분에 다이노v3 위에 간단한 도구만 얹으면 된다. 적은 양의 학습 데이터만 있어도 좋은 결과를 얻을 수 있다.

◇ 환경과 우주 분야에서 성능 입증

다이노v3는 실제 현장에서도 효과를 보이고 있다. 세계자원연구소는 케냐 산림을 모니터링할 때 다이노v3를 사용했다. 그 결과 나무 높이 측정 오차가 4.1m에서 1.2m로 크게 줄었다. 이 정확도 향상은 실질적인 변화를 가져왔다. 산림 복원 결과를 검증해 기후 금융 지불을 자동화하고, 거래 비용을 줄이며, 소규모 지역 단체에 대한 자금 지원을 가속화할 수 있게 됐다.

우주항공 분야에서도 활용되고 있다. 나사(NASA)는 화성 탐사 로봇에 이 모델을 적용했다. 적은 컴퓨팅 자원으로도 좋은 성능을 냈다. 우주처럼 제한된 환경에서도 충분히 활용 가능하다는 것을 입증한 사례다.

위성 이미지 분석 분야에서도 가능성을 증명했다. 다이노v3는 위성 종류에 관계없이 사용할 수 있는 범용 백본을 만들어, 환경 모니터링, 도시 계획, 재해 대응 등 일반적인 응용을 가능하게 한다.

라벨링이 어려운 분야에서 활용 가능성은 높다. 주석이 부족하거나 비용이 많이 들거나 불가능한 응용 분야에서 다이노v3의 라벨 없는 접근법이 유용할 수 있기 때문이다. 의료 영상, 생물학적 이미지, 원격 탐사 등이 대표적인 예다.

◇ 다이노v3, 오픈소스로 공개

메타는 다이노v3를 상업용 라이선스로 완전히 공개했다. 단순히 모델 가중치만 공개한 것이 아니라, 전체 훈련 코드, 사전 훈련된 백본, 다운스트림 어댑터, 샘플 노트북 등 포괄적으로 공개했다.

공개된 모델 라인업도 다양하다. 거대한 ViT-G 백본부터 증류된 버전(ViT-B, ViT-L), 자원이 제한된 엣지 디바이스를 위한 ConvNeXt 변형까지 제공된다. 최근에는 허깅페이스허브(Hugging Face Hub)와 트랜스포머(Transformers) 라이브러리에서도 지원하기 시작했다.

이러한 오픈소스 접근 방식은 연구자와 개발자들이 주석이 부족한 작업을 해결하고, 고성능 모델을 빠르게 배포하며, 가벼운 어댑터만 교체하여 새로운 도메인에 적응할 수 있게 해준