올거나이즈가 대형언어모델(LLM) 에이전트 성능을 종합 평가하는 툴을 제공한다. 문제 해결을 자율적으로 행동하는 에이전트 시장이 커짐에 따라 해당 기능을 구현할 LLM을 평가하는 플랫폼 ‘올인원 벤치마크(All-in-One Benchmark)’를 공개한다고 3일 밝혔다.

올인원 벤치마크는 LLM의 에이전트 성능을 평가하는 플랫폼이다. LLM으로 에이전트를 구현하기 위해서는 도메인별 지식뿐 아니라 문제 해결을 위한 도구와 이를 활용할 수 있는 능력, 대화 맥락 이해, 수집된 정보 활용 등 다양한 능력이 요구된다. 올거나이즈가 공개하는 플랫폼은 공개된 벤치마크를 활용해 이러한 LLM 기능을 다각도로 분석해 대시보드 형태로 제공, 한눈에 평가 결과를 볼 수 있게 제공한다.

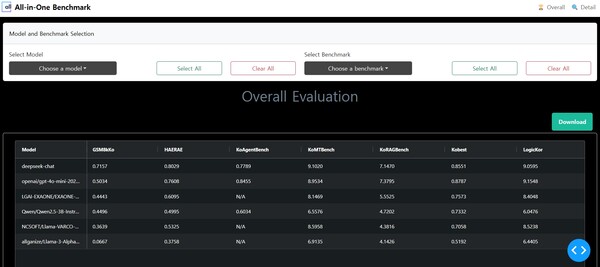

사용자는 플랫폼 내에서 올거나이즈의 자체 소형언어모델(sLLM)을 비롯한 챗GPT, 엑사원, 큐원, 딥시크 등 12개 LLM의 평가 결과를 확인할 수 있다. 에이전트 성능을 종합적으로 평가하는데는 3가지 벤치마크가 활용된다. 다양한 상황에서 스스로 외부 도구를 호출하는 ‘툴 콜링(tool calling)’ 능력을 평가하는 데는 ‘BFCL’를, 한국어 환경에서의 툴 콜링 능력 평가는 ‘FunctionChatBench’를 활용한다. ‘TauBench’라는 벤치마크를 통해서는 유통, 항공 등 실제 산업 현장의 다양한 상황에서 LLM의 문제 해결 능력을 평가한다.

새로운 LLM 성능도 확인할 수 있다. 새로 나온 LLM 이름을 입력하면 플랫폼이 모델의 응용프로그램인터페이스(API)를 자동으로 구현하고, 평가를 진행한다. 올거나이즈 측은 “LLM이 새로 개발될 때마다 각 벤치마크의 개별 코드를 실행해 동일 작업을 수차례 진행해야 하는 기존의 문제점을 해결했다”며 “대규모 데이터셋과 복잡한 벤치마크에서도 효율적인 평가가 가능해 평가 시간이 대폭 단축된다”고 밝혔다. 회사에 따르면, 동일한 모델 평가 결과 기존 벤치마크의 경우 약 1시간 30분, 올거나이즈의 플랫폼은 약 20분이 소요된다.

올거나이즈는 올인원 벤치마크를 통해 최근 오픈소스로 공개된 딥시크의 ‘V3’ 에이전트 성능을 평가했으며, ‘GPT-4o mini’와 유사한 결과를 확인했다고 밝혔다. V3는 공개 후 구글이 개발한 ‘GPQA-Diamond’, 수학 문제 해결 능력을 평가하는 ‘MATH 500’, 코드 생성 및 이해 평가 ‘Codeforces’ 등 다수의 벤치마크를 통해 성능이 평가됐지만 에이전트로서의 성능 평가는 올거나이즈가 처음이다.

올인원 벤치마크는 에이전트 역할뿐 아니라 일반적인 언어 이해, 지식수준, 명령 준수(Instruction Following) 등 LLM의 성능을 종합적으로 평가한다. 이 역시 ‘ArenaHard’, ‘Kobest’, ‘HAERAE’ 등 공개된 벤치마크가 활용된다. 플랫폼에서 선택할 수 있는 벤치마크는 총 12개로 모델 별 비교 분석이 용이하다. 결과는 100 이하, 소수점 4자리까지 숫자로 표시되고 벤치마크 별로 최고점이 상이하다.

이창수 올거나이즈 대표는 “기업이 생산성 향상을 위해 AI 모델을 도입하는 데 도움이 되는 LLM 평가 플랫폼을 지속적으로 업데이트해 나갈 예정”이라며 “나아가 에이전트 역할을 제대로 수행하는 LLM을 개발하기 위해 기존 LLM의 에이전트 성능을 확인하고 이를 향상시키기 위한 학습 방법을 심도 있게 연구하고 있다”고 말했다.